El machine learning y sus sesgos

Por Enrique Dans*

La alerta comenzó en Twitter: un emprendedor y creador de Ruby on Rails con más de 250,000 seguidores, David Heinemeier Hansson, compartía un hilo en el que detallaba como su mujer, que había solicitado la misma Apple Card que él, únicamente obtenía un límite de crédito unas veinte veces inferior que el suyo, a pesar de que declaraban impuestos conjuntamente y de que, además, ella tenía mejor historial de crédito que él.

En su explícita reclamación, que rápidamente se viralizó con el testimonio de otras personas que habían experimentado casos similares, afirmaba haber apelado a la compañía y no haber obtenido respuesta, y logró poner en marcha todas las alarmas, desencadenar una investigación del New York State Department of Financial Services por discriminación de género, y llevar a que la entidad emisora de la tarjeta, Goldman Sachs, anunciase que reevaluaría el cálculo de sus límites de crédito.

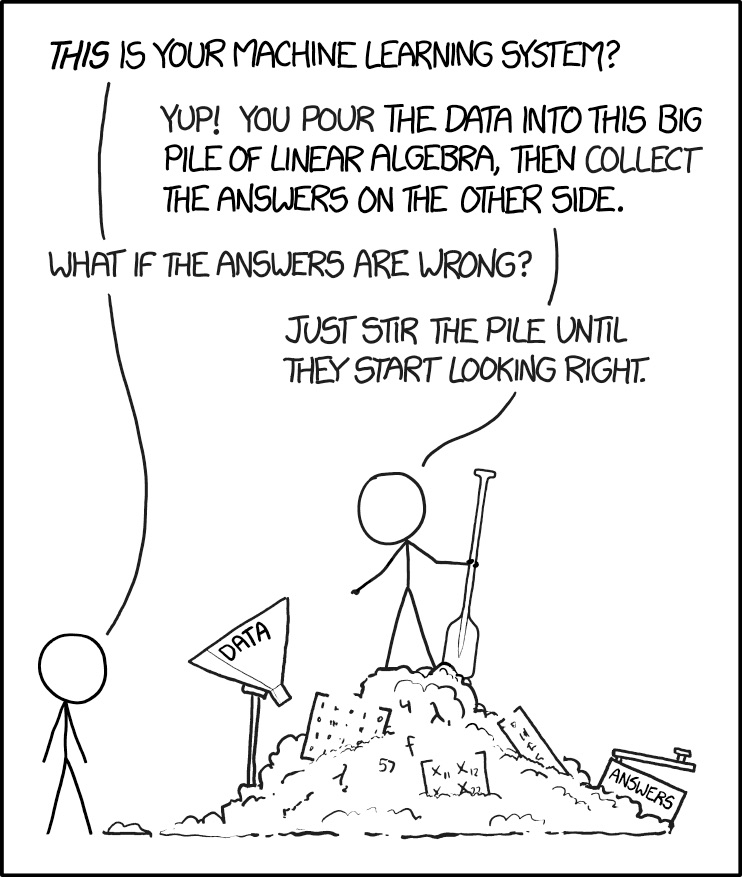

La queja de David, en la que hacía exclusivamente responsable del problema a Apple, resulta curiosa viniendo de un desarrollador con experiencia: un sistema de machine learning es tan bueno como los datos con los que lo alimentamos, y no hace tanto tiempo que la sociedad, de manera generalizada en los países desarrollados, sostenía importantes sesgos en función del género de las personas, particularmente en entornos financieros. Obviamente, eso era algo que había que corregir, y en la mayoría de esos países desarrollados se está en vías de hacerlo – podríamos discutir si se hace o no con la velocidad adecuada – pero eso, me temo, no impide que muchos de los datos que utilizamos aún provengan de épocas en las que ese sesgo era un componente significativo de las sociedades occidentales (y en otras es aún peor).

El sesgo en los algoritmos de machine learning no indica necesariamente ningún tipo de intencionalidad ni de discriminación en la empresa que comercializa un producto o servicio. La discriminación, obviamente, sí se produce de facto, y por tanto, debe ser corregida, algo que precisamente puede hacerse a partir de las denuncias de los usuarios, que son quienes, en último término, pueden experimentarla. Pensar que los algoritmos reflejan algún tipo de intencionalidad es como pensar que son infalibles, cuando en realidad, son simples procesos matemáticos que procesan datos. Si esos datos están sesgados en su origen, esos sesgos reaparecen en sus decisiones, y será así mientras ese sesgo original en los datos no se corrija o sea matemáticamente descontado mediante métodos que corrijan el sesgo muestral o sample bias. Es un tema que llevo años comentando en mis clases con ejemplos de diversos tipos, y que no resulta tan difícil de entender.

El machine learning se está convirtiendo en una de las tecnologías más interesantes y prometedoras para obtener una automatización de procesos infinitamente más sofisticada, potente y flexible que la que disfrutábamos cuando simplemente programábamos dando nombre a variables y planteando condicionales y bucles. Aplicar machine learning supone acceder a reglas muchísimo más inteligentes, potentes y flexibles, que se van corrigiendo a medida que los datos de la muestra van evolucionando, que reconocen variaciones en función de muchísimos factores, y que tienen capacidad para ir haciéndose mejores con el tiempo. Se habla, incluso, de utilizar la historia como una enorme base de datos para alimentar algoritmos, algo que requerirá la participación de perfiles de muy diversos tipos.

Suponer algún tipo de «perversidad» en los algoritmos o en las compañías que los utilizan y dedicarse a acusar a Apple de machismo es, a estas alturas de película, tan ingenuo como suponer que los algoritmos son correctos porque provienen de algún tipo de bola de cristal o poder místico. No, no es así: el machine learning es y será durante mucho tiempo un generador de algoritmos sesgados debido a los datos con los que alimentamos los algoritmos, sesgos que habrá que vigilar, controlar y eventualmente corregir. Las protestas tienen valor, y lo único que hay que reclamar es que las compañías investiguen los efectos de sus algoritmos cuando se intuyan comportamientos discriminatorios, y los corrijan, aunque sea manualmente, cuando sea necesario, y realimenten sus algoritmos con esas correcciones. No, no toda discriminación es resultado de algún tipo de mala intención o sesgo explícito, a veces son sesgos implícitos no necesariamente fáciles de visualizar que provienen, simplemente, de la matemática.

El machine learning va a estar en todas partes, el mercado del Machine Learning as a Service (MLaaS) va a crecer muchísimo en los próximos años, y además, es muy posible que separe a las compañías que triunfan gracias a su sofisticada automatización de aquellas que fracasan por seguir haciendo las cosas como las hacían tradicionalmente. Cuando utilices machine learning, asume que es posible que surjan sesgos que no has tenido en cuenta porque provenían de los datos originales, y prepárate para saber darles respuesta adecuada y rápidamente si aparecen. Si automatizas, sé sensible a los posibles problemas y sesgos que surgen de esa automatización. Vamos a convivir con algoritmos de manera habitual, y ello conllevará que tanto las empresas que los utilizan como los clientes que los experimentan sepan que ni son perfectos, ni tienen necesariamente la razón… aprendamos a reconocer esto sin pensar en conspiraciones y sin hacer dramas al respecto.

*Texto íntegro e imágenes, publicados gracias a licencias Creative Commons